„Dlaczego istnieje raczej coś niż nic? Nic jest przecież prostsze i łatwiejsze niż coś”. To stwierdzenie Gottfrieda Leibniza dobrze oddaje wyniki pracy prof. Jamesa Toura, znanego chemika syntetycznego z Uniwersytetu w Rice. Tour dokonał przeglądu stanu badań nad zagadnieniem abiogenezy – spontanicznego powstania życia. Na temat możliwości powstania życia z materii nieożywionej wypowiadało się wielu naukowców, ale jedynie nieliczni mają w tym względzie podobne kompetencje co James Tour, autor ponad 700 publikacji naukowych (z ponad 100 tysiącami cytowań) i właściciel 140 patentów, a także członek Royal Society of Chemistry oraz National Academy of Inventors. W 2019 roku portal TheBestSchools.org uznał go za jednego z pięćdziesięciu najbardziej wpływowych naukowców na świecie1. Po przeglądzie stanu badań nad abiogenezą Tour stwierdził, że jest zaszokowany rozdźwiękiem pomiędzy optymistycznym obrazem często przedstawianym na ten temat w mediach a wnioskami, które faktycznie wypływają z naukowej literatury. Profesor Tour zauważa:

Życie nie powinno było istnieć. Tyle wiemy z chemii. Jałowość biologiczna innych planet ma – z punktu widzenia chemii – znacznie więcej sensu niż wyjątkowość życia na Ziemi. […] Prawa fizyki i układ okresowy pierwiastków są uniwersalne, co sugeruje, że życie istniejące dzięki aminokwasom, nukleotydom, węglowodanom i lipidom jest anomalią. Życie nie powinno istnieć we Wszechświecie. Życie nie powinno nawet istnieć na powierzchni Ziemi2.

Tour wskazuje, że sytuacja jest gorsza niż w 1952 roku, kiedy Stanley Miller i Harold Urey otrzymali z prostszych związków kilka racemicznych aminokwasów. Od tego czasu procedura badań nad powstaniem życia nie zmieniła się znacząco – można ją opisać w ten sposób: zakup duże ilości oczyszczonych chemikaliów, wymieszaj je w dużych stężeniach i w określonej sekwencji w starannie kontrolowanym laboratoryjnym środowisku, odfiltruj mieszaninę składników i opublikuj artykuł z przesadzonymi twierdzeniami na temat możliwości powstania życia3.

Tour omawia następnie bardziej szczegółowe problemy, o których nie wspomina się zbyt głośno w badaniach nad abiogenezą: problem syntezy, problem montażu i problem informacji. Dwa pierwsze to domena chemii; trzeci wychodzi znacznie dalej.

Problem syntezy

Problem syntezy sprowadza się do faktu, że aby otrzymać podstawowe „budulce życia”, konieczne są projektowanie i starannie zaaranżowany proces ich budowy za pomocą zaawansowanych technik chemii syntetycznej – proces, który nie ma nic wspólnego z symulowaniem prebiotycznych warunków na pierwotnej Ziemi. Tour wskazuje na następujące fakty:

- Molekuły tworzące żywe organizmy prawie zawsze są homochiralne, to znaczy, że warianty tej samej cząsteczki nie są identyczne i nie można ich nałożyć na siebie na drodze translacji i obrotu w przestrzeni na podobieństwo prawej i lewej dłoni. Uzyskanie i izolacja cząsteczek homochiralnych w procesie chemicznej syntezy jest trudne.

- Ciąg chemicznych reakcji jest przypadkowy w tym sensie, że nie zmierza do żadnego określonego celu i nie zatrzymuje się w „odpowiednim dla życia” momencie. W laboratorium eksperymentatorzy często muszą interweniować i zatrzymać ciąg reakcji, aby pożądane molekuły nie uległy dalszym reakcjom i degradacji. Naturalistyczne procesy nie mają tego typu założonego celu.

- Kolejny problem to zagadnienie upływającego czasu – sądzi się, że duże skale czasu sprzyjają abiogenezie. W rzeczywistości jest odwrotnie: przykładowo węglowodany są produktami kinetycznymi i łatwo ulegają rozpadowi oraz polimeryzacji, jeśli nie zatrzyma się reakcji w odpowiednim momencie.

- Brak naturalistycznego mechanizmu oczyszczania i filtrowania molekuł. Jeśli nie ma takiego mechanizmu, „właściwe” cząsteczki ulegają wymieszaniu z dużą ilością innych molekuł, które blokują pożądany ciąg reakcji.

- By otrzymać jakiś pożądany produkt, należy mieszać ze sobą odczynniki w ściśle określonej kolejności. Dodanie wszystkich naraz lub w innej kolejności sprawi, że oczekiwana reakcja nie dojdzie do skutku.

- Wszystkie parametry, jak temperatura, ciśnienie, światło lub jego brak, skala pH, dostęp atmosferycznych gazów lub ich brak, muszą być starannie kontrolowane, by otrzymać złożone cząsteczki.

- Transfer mas. Częstym punktem wyjścia procesu syntezy złożonych cząsteczek są znaczne ilości „surowca”, z którego otrzymuje się jedynie niewielkie ilości końcowych cząstek. Innymi słowy, by zapewnić powstanie końcowego produktu, konieczne jest dostarczanie znacznie większych ilości – zwykle oczyszczonych – substancji wyjściowych.

Jako przykład Tour wskazuje na badania nad RNA – uznawanym przez wielu naukowców za obiecujący biopolimer, ponieważ może on zarówno kodować biologiczną informację, jak i ma właściwości katalityczne. W omawianych eksperymentach naukowcy stosowali specjalny rodzaj glinki – ponieważ powierzchnia glinki jest naładowana dodatnio, może ona wiązać ujemnie naładowane rybonukleotydy, co ułatwia ich polimeryzację. Punktem wyjściowym dla tych badań nie była jednak glina pobrana gdzieś spod kamienia. Dla odmiany użyto komercyjnie dostępnego produktu zwanego Volclay, który najpewniej już zawierał rozmaite domieszki. Oto opis fragmentu procedury przygotowania tego eksperymentu:

Volclay® (12 g) poddany został działaniu 0,5 M HCl (50 ml) przez ciągłe mieszanie przez 30 minut w temperaturze 4 stopni C. Pod koniec każdego cyklu nadmiar kwasu został usunięty przez odwirowanie (3500 rpm) i dekantowanie nadsącza. Świeży kwas (50 ml) został dodany do grudki montmorylonitu, a cały proces powtórzono dwa razy. H+ montmorylonit był przez 30 minut płukany przez 100 ml zdejonizowanej wody w temperaturze 4 stopni C przy ciągłym mieszaniu. Pod koniec płukania nadmiar wody został usunięty przez odwirowanie (3500 rpm), a nadsącze odciągnięto. Płukanie wodą (100 ml) powtórzono trzy razy. Zaczyn H+ montmorylonitu został dodany do wody (1000 ml), do tego dodano 45 ml żywicy anionowymiennej w celu usunięcia resztek HCl. Mieszanka była przez 30 minut mieszana, odczyn pH został zmierzony (3,00 ± 0,2), żywica anionowymienna została usunięta za pomocą filtrowania przez nierdzewne sito (rozmiar oka w sieci 115), a zaczyn H+-montmorylonitu został usunięty i liofilizowany. Jeden gram H+ montmorylonitu umieszczono w 100 ml zdejonizowanej wody i miareczkowano do pH 7 przy użyciu 0,02 M roztworu NaOH, LiOH lub KOH. Woda została następnie usunięta przez odwirowanie (3500 rpm), a grudki Li+, Na+ i K+-montmorylonitu liofilizowane4.

Cały ten starannie zaaranżowany proces dotyczy tylko jednego z wielu kroków przygotowania eksperymentu. Skąd na pierwotnej Ziemi wzięły się żywica, filtry, wirówki 3500 rpm i komory próżniowe do suszenia sublimacyjnego? „To problem pierwotnej Ziemi, a nie nasz” – zdają się odpowiadać naukowcy zajmujący się zagadnieniem pochodzenia życia.

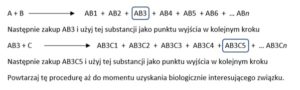

Profesor Tour zwrócił także uwagę na fakt, że wyniki tego typu prac zwykle nie podają ilości docelowych substancji, które udało się otrzymać, a które mogą stanowić elementy budulca komórki. Jest tak dlatego, ponieważ otrzymana ilość tych docelowych substancji jest najczęściej śladowa. Naukowcy zajmujący się zagadnieniem pochodzenia życia uciekają się tu do sztuczki zwanej „syntezą sztafetową”, gdzie punktem wyjścia do kolejnego etapu syntezy nie są śladowe ilości substancji otrzymanej w poprzednim kroku, ale zakupione duże ilości oczyszczonej wymaganej substancji. W syntezie sztafetowej badacze zaczynają od dwóch związków: A i B, otrzymując w reakcjach związki AB1, AB2, AB3 i tak dalej. Załóżmy, że interesuje ich związek AB3, który pojawia się w śladowych ilościach. I co robią dalej? Odfiltrowują związek AB3 i używają go w następnym kroku? W żadnym wypadku – po prostu kupują w dużych ilościach (lub syntetyzują) oczyszczony związek AB3 i używają go jako punktu wyjścia w kolejnym kroku syntezy.

Do zakupionego AB3 dodają następnie substancję C, otrzymując AB3C1, AB3C2, AB3C3 i tak dalej. Teraz interesuje ich związek AB3C5, który także pojawia się w śladowych ilościach. I znowu – zamiast do kolejnego kroku używać śladowych ilości otrzymanego związku kupują oni duże ilości związku AB3C5, którego używają jako punktu wyjścia w kolejnym kroku syntezy.

Praktykę tę można następująco zilustrować:

Procedura ta powtarzana jest aż do momentu, gdy otrzymuje się jakiś biologicznie interesujący związek, po czym obwieszcza się to jako wielki sukces realistycznych symulacji warunków panujących na pierwotnej Ziemi.

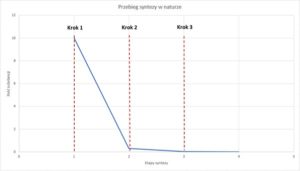

W naturze proces powstawania docelowego związku w wyniku ciągu reakcji musiałby przypominać następującą krzywą:

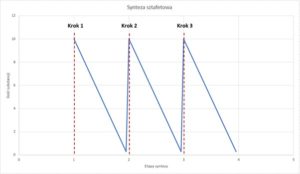

Gdzie śladowe ilości substancji otrzymywane w każdym kroku są punktem wyjścia dla kolejnego kroku i maleją w kolejnych etapach. Eksperymenty laboratoryjne wyglądają jednak zupełnie inaczej, co zilustrować można następująco:

Skąd ten wzrost ilości substancji przed każdym kolejnym krokiem syntezy? Otóż do rozpoczęcia kolejnych kroków używa się dużych ilości zakupionej substancji, a nie otrzymanych w poprzednim kroku. Tour tłumaczy, dlaczego tak właśnie się postępuje: śladowe ilości pożądanych substancji wymieszane są z rozmaitymi zanieczyszczeniami, które także powstają w wyniku reakcji, a które blokują kolejne kroki syntezy. Innymi słowy, trzymając się realistycznej symulacji, nigdy nie otrzymalibyśmy biologicznie interesującego związku, ponieważ śladowe ilości substratów rozcieńczone byłyby w morzu zanieczyszczeń.

Problem montażu

Problem syntezy to jednak dopiero początek. Nawet mając w jednym miejscu wszystkie wymagane molekuły, musiałyby one ułożyć się w odpowiednią, ściśle określoną konfigurację, która mogłaby dać początek żywej komórce. Załóżmy, że zapominamy o problemie syntezy i mamy w jednym sterylnym miejscu wszystkie wymagane związki chemiczne, jak RNA, DNA, białka i lipidy, pobrane na przykład z żywych organizmów. Dlaczego mieszanie takich gotowych komponentów nigdy nie doprowadziło do powstawania żywych komórek? Powodem tego jest rachunek prawdopodobieństwa.

Naukowcy określili minimalne wymagania konieczne do powstania i funkcjonowania żywej komórki5. Musi ona posiadać co najmniej trzy kluczowe cechy:

- Jakąś formę metabolizmu, która byłaby w stanie dostarczać podstawowych molekularnych cząstek i energii koniecznej do syntezy komórkowych komponentów.

- Mechanizm genetycznej replikacji z jakiegoś szablonu i mechanizm transferu tej informacji.

- Błonę komórkową, która oddzielałaby komórkę od jej otoczenia.

Najprostszy, „minimalny” genom, jaki znamy, gdzie posiadający go organizm jest zdolny do samodzielnej replikacji i wzrostu, należy do bakterii Mycoplasma genitalium. Genom ten posiada 470 genów, co przekłada się na 580 tysięcy nukleotydów. Niektórzy naukowcy sugerują, że tego rodzaju genom może zostać jeszcze uproszczony: minimalny teoretyczny genom może wynosić od 206 do 256 genów. Musi zawierać geny kodujące białka, które to białka pełnią następujące funkcje: replikacja, naprawa i modyfikacja DNA, mechanizm transkrypcyjny i translacyjny, synteza i modyfikacja transportowego DNA, budowa rybosomów i ich funkcja, degradacja RNA, przetwarzanie innych białek, jak pomoc w ich fałdowaniu się, system transportu komórkowego i jego podziału oraz szereg ścieżek metabolicznych, jak glikoliza, metabolizm tłuszczów i biosynteza nukleotydów.

Autorzy wspomnianej pracy stwierdzają także, że taka „minimalna” komórka zależałaby od ciągłego transportu z zewnętrznego otoczenia szeregu substratów, w tym wszystkich dwudziestu aminokwasów, ponieważ teoretyczny minimalny genom nie miałby możliwości ich syntezy.

Jak zatem wszystkie te komponenty mogą zostać złożone w funkcjonalną całość, która dałaby początek żywej komórce? Jak mogłoby powstać to, co określa się mianem interaktomu – zbioru molekularnych funkcjonalnych interakcji wewnątrz komórki (termin bardzo rzadko używany w badaniach nad pochodzeniem życia).

Peter Tompa i George Rose w czasopiśmie „Protein Science” napisali:

Centralne pytanie biologii XXI wieku jest następujące: jak żywa komórka powstaje ze zdumiewającej kombinatorycznej złożoności jej molekularnych składników? W tym artykule szacujemy kombinatorykę spontanicznego montażu białek komórki drożdży, liczbę tak wielką, że funkcjonalny interaktom mógł pojawić się jedynie w rezultacie sekwencyjnego, hierarchicznego procesu montażu jego składników6.

Warto zwrócić uwagę na ostatnie zdanie: interaktom mógł powstać jedynie w wyniku sekwencyjnego, hierarchicznego procesu montażu jego komponentów. Tak właśnie tworzymy złożone systemy w naszej inżynierii.

Dlaczego autorzy wspomnianego artykułu twierdzą, że spontaniczne złożenie się interaktomu jest niezwykle mało prawdopodobne? Przyczyna tkwi w kombinatoryce i prawdopodobieństwie. Biorąc pod uwagę jedynie możliwe przestrzenne kombinacje białek w pojedynczej komórce drożdży – a zatem bez uwzględnienia kombinacji białka-DNA, białka-RNA i RNA-DNA, liczba takich możliwych kombinacji białek to 1079 000 000 000, czyli 10 i 79 miliardów zer – olbrzymia większość z tych kombinacji byłaby niefunkcjonalna. Dla porównania: liczba szacowanych cząstek elementarnych w obserwowalnym Wszechświecie wynosi 1080. Jest ona tak wielka, że autorzy wspomnianego artykułu twierdzą, że uformowanie się funkcjonalnego interaktomu w wyniku losowo oddziałujących na siebie cząstek jest poza zasięgiem jakiegokolwiek dostępnego przedziału czasu. „To numeryczne ćwiczenie, »paradoks interaktomu Levinthala«, jest równoznaczne z wykazaniem, że komórka nie powstaje w wyniku przypadkowych zderzeń jej składników” – podsumowują Tompa i Rose7.

Opinia Tompy i Rose’a teoretycznie ma sens. Do zestawienia złożonego funkcjonalnego systemu wymagana jest praca. Proces budowy polega zaś na wyborze specyficznych konfiguracji z olbrzymiego zakresu wszystkich możliwych.

Właściwe przestrzenne ułożenie składników komórki jeszcze nie wystarczy do jej samodzielnego funkcjonowania. Musi istnieć także odpowiedni, kierunkowy system przepływu energii, który utrzymywałby komórkowe procesy w stanie dynamicznej równowagi. Yasar Demirel w czasopiśmie „Entropy” wyjaśnił, w czym rzecz: aby kierunkowy przepływ materii i energii w komórce był funkcjonalny i mógł służyć właściwym celom, musi być sterowany przez informację. Demirel podał następujące równanie: „W przypadku żywych systemów informacja jest przyczyną, a redukcja entropii skutkiem: energia + materia + informacja = lokalna redukcja entropii (wzrost uporządkowania)”8.

W ten sposób dochodzimy do największego i najważniejszego problemu, na który musi odpowiedzieć koncepcja abiogenezy: problemu powstania informacji.

Problem informacji

Jednym z największych odkryć biologii molekularnej jest to, że informacja steruje biologicznymi procesami. Jak to ujął noblista i były dyrektor Kalifornijskiego Instytutu Technicznego David Baltimore: „współczesna biologia to nauka o informacji”. Aby mogła powstać nowa biologiczna cecha, struktura czy funkcja, potrzebne są białka, zbudowane z mniejszych jednostek zwanych aminokwasami. Takie białka powinny oczywiście pełnić określone funkcje, co w dalszej kolejności zależy od sekwencji aminokwasów (czyli właściwa liczba aminokwasów ułożona w odpowiedniej kolejności). Dopiero wtedy takie białko może sfałdować się w trójwymiarową strukturę, która jest kluczowa dla jego funkcjonalności. Gdzie zatem znajdują się instrukcje, w jaki sposób ułożyć ciąg aminokwasów? Na to pytanie poznaliśmy odpowiedź w latach pięćdziesiątych i sześćdziesiątych ubiegłego wieku, kiedy James Watson i Francis Crick rozszyfrowali strukturę cząsteczek kwasu deoksyrybonukleinowego – DNA. Opisanie fizycznej struktury DNA to był dopiero pierwszy krok, kolejny przełom nastąpił kilka lat później, gdy Crick rozpoznał informacyjną naturę sygnału zakodowanego w DNA. Ten angielski biolog molekularny podczas II wojny światowej służył jako kryptolog, co z pewnością pomogło mu rozszyfrować genetyczny „kod życia”. Według sformułowanej przez Cricka „hipotezy sekwencyjności” cztery zasady nukleotydowe (adenina i guanina oraz cytozyna i tymina) w łańcuchu DNA funkcjonują niczym symbole kodu maszynowego lub litery alfabetu, określając tym samym sekwencję aminokwasów zgodnie z odpowiednim systemem symbolicznego kodowania. Innymi słowy, stosowne ułożenie aminokwasów w łańcuchu białkowym, które umożliwia białku właściwe fałdowanie się, jest wynikiem odpowiedniego ułożenia nukleotydów wzdłuż łańcucha DNA. Podobnie jak litery alfabetu w języku pisanym mogą pełnić funkcję komunikacyjną zależną od ich sekwencji ‒ tak sekwencja nukleotydów w DNA decyduje o funkcjonalności białka (lub jej braku). W obu przypadkach funkcja zależy od sekwencji.

Odkrycie, że cyfrowa informacja steruje konfigurowaniem białek, zrodziło jednocześnie pytanie: skąd ta informacja pochodzi? Jak ujął to Bernd-Olaf Küppers: „Istota problemu powstania życia jest najwyraźniej równoznaczna z problemem powstania informacji biologicznej”9. Tego typu symboliczne kodowanie, gdzie pewien specyficzny układ danego nośnika reprezentuje jakąś informację, znane jest jedynie jako dzieło inteligencji. Naturalne procesy mogą wytwarzać regularności (np. pulsary emitujące regularne impulsy czy struktury kryształów), ale nigdy nie zaobserwowano, by wytworzyły one symboliczną informację połączoną z systemem jej interpretacji. Związki chemiczne mogą być nośnikiem informacji, ale nie jej źródłem. Zasady chemii opisują zarówno interakcje pośród cząstek, jak i kwantowe przejścia pomiędzy różnymi stanami cząstki. Nic w tych zasadach nie gwarantuje jednak formowania się specyficznych sekwencji nukleotydowych i mapowanego na nie symbolicznego kodu genetycznego. Pomocna będzie tu analogia z tablicą magnetyczną i namagnesowanymi literami alfabetu. Wykorzystując przyciąganie magnetyczne, możemy do takiej tablicy przyczepiać litery, tworząc sensowne słowa i zdania. W zasadach rządzących magnetyzmem nie ma jednak niczego, co gwarantowałoby czy preferowałoby powstawanie sensownych zdań. To, czy dane ułożenie liter niesie sens, dla magnetyzmu nie ma najmniejszego znaczenia.

W rzeczy samej, doszukiwanie się czegoś takiego w chemii czy fizyce nie ma sensu. Jak to wyraził w swojej najnowszej książce Demon w maszynie znany fizyk Paul Davies, informacja semantyczna to koncept wyższego rzędu, który na poziomie molekuł nie ma po prostu sensu. Sama chemia, niezależnie jak bardzo złożona, nigdy nie wytworzy kodu genetycznego czy instrukcji zależnych od kontekstu. Oczekiwać, by chemia wyjaśniła zakodowaną informację, to jak spodziewać się, że hardware komputera napisze własny software10.

Nośnik chemii przenosi wiadomość życia, ale nośnik sam w sobie nie może generować wiadomości – informacji. Sugerować co innego ‒ to jakby twierdzić, że atrament i papier mają zdolność zorganizować się same z siebie w niosący znaczenie tekst.

Problemy syntezy, montażu i informacji sprawiają, że koncepcja abiogenezy zaczyna przypominać współczesną wersję alchemii – starożytnego przekonania, że ołów można zamienić w złoto. A im więcej wiemy o złożoności żywej komórki, tym mniej prawdopodobne są koncepcje spontanicznego jej powstania.

Symboliczne kodowanie, informacja, systemy korekcji błędów – wszystko to może wskazywać, że rozumny projekt jest najlepszym wyjaśnieniem powstania życia. James Tour nie idzie jednak tak daleko. Profesor wyjaśnia, że powodem, dla którego przedstawił tak wyczerpującą krytykę stanu badań nad powstaniem życia, był rozdźwięk między tym, jak badania przedstawia się szerokiej publice a co faktycznie wynika z technicznej literatury. Tour wzywa do przegrupowania sił i środków. Pierwszym zaś krokiem powinno być jasne przyznanie się do tego, czego nie potrafimy jeszcze wyjaśnić, a mianowicie powstania molekuł wymaganych do życia, powstania kodów używanych przez żywe komórki, kombinatorycznej złożoności żywych systemów i precyzyjnego montażu komórkowych komponentów. Dopiero wtedy badania nad powstaniem życia będą miały szansę przynieść coś nowego.

Piotr Kublicki

Źródło zdjęcia: Pixabay

Ostatnia aktualizacja strony: 06.10.2021

Przypisy

- Por. James M. Tour Group na Stronach Uniwersytetu w Rice [dostęp 10 V 2021].

- J. Tour, An Open Letter to My Colleagues, „Inference Review” 2017, Vol. 3 [dostęp 10 V 2021].

- Por. J. Tour, Time Out, „Inference Review” 2019, Vol. 4 [dostęp 10 V 2021].

- S. Jheeta, P.C. Joshi, Prebiotic RNA Synthesis by Montmorillonite Catalysis, „Life” 2014, Vol. 4, s. 320 [318–330].

- Por. J.C. Xavier, K.R. Patil, I. Rocha, Systems Biology Perspectives on Minimal and Simpler Cells, „Microbiology and Molecular Biology Reviews” 2014, Vol. 78, s. 487–509.

- Por. P. Tompa, G.D. Rose, The Levinthal Paradox of the Interactome, „Protein Science” 2011, Vol. 20, s. 2074 [2074–2079].

- Tompa, Rose, The Levinthal Paradox, s. 2075.

- Y. Demirel, Information in Biological Systems and the Fluctuation Theorem, „Entropy” 2014, Vol. 16, s. 1940 [1931–1948].

- B.O. Küppers, Geneza informacji biologicznej. Filozoficzne problemy powstania życia, tłum. W. Ługowski, PWN, Warszawa 1991, s. 173.

- Por. P. Davies, Demon w maszynie. Jak ukryte sieci informacji wyjaśniają tajemnicę życia, tłum. T. Lanczewski, Copernicus Center Press, Kraków 2020.

Literatura:

- Davies P., Demon w maszynie. Jak ukryte sieci informacji wyjaśniają tajemnicę życia, tłum. T. Lanczewski, Copernicus Center Press, Kraków 2020.

- Demirel Y., Information in Biological Systems and the Fluctuation Theorem, „Entropy” 2014, Vol. 16, s. 1931–1948.

- Jheeta S., Joshi P.C., Prebiotic RNA Synthesis by Montmorillonite Catalysis, „Life” 2014, Vol. 4, s. 318–330.

- Küppers B.O., Geneza informacji biologicznej. Filozoficzne problemy powstania życia, tłum. W. Ługowski, Warszawa 1991.

- Tompa P., Rose G.D., The Levinthal Paradox of the Interactome, „Protein Science” 2011, Vol. 20, s. 2074–2079.

- Tour J., An Open Letter to My Colleagues, „Inference Review” 2017, Vol. 3 [dostęp 10 V 2021].

- Tour J., Time Out, „Inference Review” 2019, Vol. 4 [dostęp 10 V 2021].

- Xavier J.C., Patil K.R., Rocha I., Systems Biology Perspectives on Minimal and Simpler Cells, „Microbiology and Molecular Biology Reviews” 2014, Vol. 78, s. 487–509.